⚡ Quick Facts

- Massive 48 GB Kapazität pro 16-hi Stack demonstriert

- Interface-Breite auf 2.048 Bit verdoppelt (vgl. HBM3E)

- Geschwindigkeiten von bis zu 10 GT/s erreicht

Endlich sehen wir echte Hardware statt nur bunter Roadmap-Folien: Der neue HBM4 Speicherstandard ist real, und SK Hynix hat soeben die Muskeln spielen lassen. Wir schreiben den 17. Januar 2026, und während Consumer-Grafikkarten immer noch geizig mit dem VRAM umgehen, sprengt der High-Performance-Computing-Sektor (HPC) gerade alle physikalischen Grenzen. Der Flaschenhals bei modernen KI-Modellen ist längst nicht mehr die reine Rechenleistung der GPU selbst, sondern wie schnell wir die gigantischen Datenmengen in die Recheneinheiten schaufeln können. Genau hier setzt die neueste Generation an und verspricht, die Datenautobahnen in Rechenzentren massiv zu verbreitern.

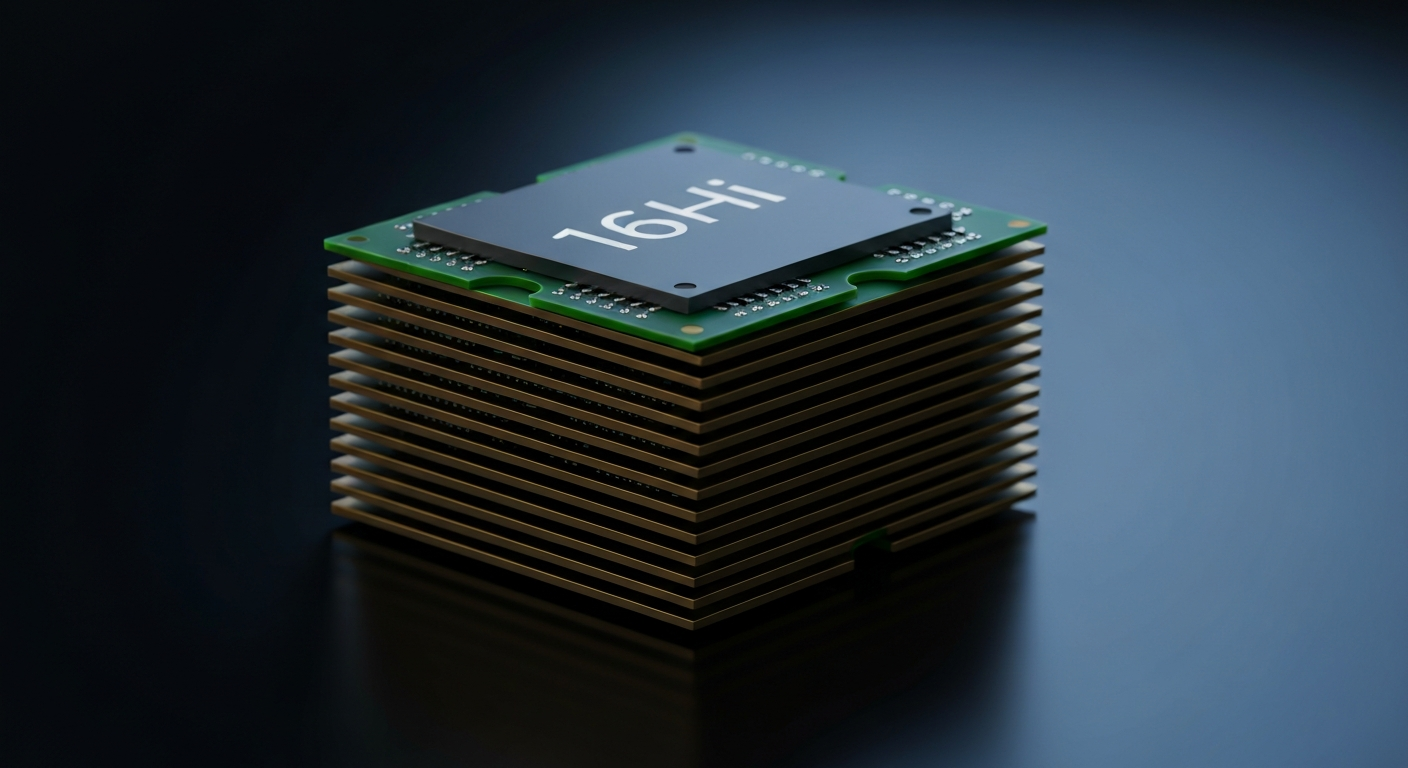

SK Hynix demonstriert hier nicht irgendein theoretisches Konzept für die ferne Zukunft, sondern einen funktionierenden 16-hi Stack mit unglaublichen 48 GB Kapazität pro Chip. Das ist eine technische Ansage, die Nvidia und AMD gleichermaßen aufhorchen lässt, denn der Hunger nach Speicherbandbreite ist im KI-Zeitalter absolut unersättlich. Wenn wir über Beschleuniger der nächsten Generation sprechen, ist Speicherbandbreite die Währung, in der bezahlt wird. Die gezeigten Spezifikationen deuten darauf hin, dass wir uns auf einen massiven Leistungssprung gefasst machen können, der Training und Inferenz von Large Language Models (LLMs) deutlich beschleunigen wird. Es ist der klassische „Hubraum statt Spoiler“-Ansatz, nur eben auf mikroskopischer Silizium-Ebene.

Was ist passiert? (HBM4 Update)

SK Hynix hat auf der jüngsten Präsentation die Katze aus dem Sack gelassen und die Spezifikationen für ihre kommende Speichergeneration konkretisiert. Das Herzstück der Ankündigung ist ein 16-hi Stack – also 16 übereinander gestapelte Speicher-Dies – der eine Gesamtkapazität von 48 GB erreicht. Das ist an sich schon beeindruckend, aber die wahre Revolution findet beim Interface statt. Im Gegensatz zu den Vorgängern, die meist auf ein 1024-Bit Interface setzten, nutzt dieser neue Speicher ein 2.048-Bit breites Interface. Das ist effektiv eine Verdopplung der Fahrspuren auf der Datenautobahn, was niedrigere Taktraten bei gleichem Durchsatz oder eben brachialen Durchsatz bei hohen Taktraten ermöglicht.

Kombiniert wird diese Breite mit einer Geschwindigkeit von bis zu 10 Gigatransfers pro Sekunde (GT/s). Für den Endanwender mag das abstrakt klingen, aber für Systemarchitekten bedeutet es, dass ein einziger Stack Bandbreiten liefert, für die man früher mehrere Module bündeln musste. Diese Technologie zielt primär auf KI-Beschleuniger und Supercomputer ab, wo Latenz und Durchsatz über Sieg oder Niederlage beim Modell-Training entscheiden. Die Integration eines solchen 2048-Bit-Interfaces erfordert jedoch auch neue Ansätze im Packaging, da die Verdrahtung auf dem Interposer – der Verbindungsplatte zwischen GPU und Speicher – deutlich komplexer wird.

| Merkmal | SK Hynix HBM4 Detail |

|---|---|

| Stack-Höhe | 16-Hi (16 Schichten) |

| Kapazität pro Stack | 48 GB |

| Interface-Breite | 2.048 Bit |

| Geschwindigkeit | Bis zu 10 GT/s |

Die Auswirkungen auf den Markt sind kaum zu überschätzen. Mit 48 GB pro Stack könnten zukünftige High-End-Beschleuniger, die oft mit 4, 6 oder 8 dieser Stacks bestückt sind, über VRAM-Kapazitäten von 192 GB bis hin zu 384 GB verfügen. Das erlaubt es, noch gigantischere Parameter-Sets direkt im schnellen Speicher zu halten, ohne auf den langsamen System-RAM auslagern zu müssen. HBM4 ist damit der Treibstoff, den die nächste Welle der generativen KI dringend benötigt, um effizienter zu skalieren.

Der LazyTechLab Check

Wir müssen über das 2.048-Bit Interface sprechen, denn das ist der eigentliche Gamechanger dieser Ankündigung. Bisherige High Bandwidth Memory Generationen haben sich oft über Taktsteigerungen definiert, was thermisch immer problematischer wurde. Durch die Verdopplung der Busbreite bei HBM4 geht SK Hynix einen intelligenteren Weg: Breiter statt nur schneller. Das ist vergleichbar mit einer Autobahn, die von vier auf acht Spuren erweitert wird – der Verkehr fließt schneller ab, ohne dass die einzelnen Autos (Datenpakete) zwangsläufig Schallgeschwindigkeit erreichen müssen. Das entlastet die thermische Bilanz des Speichers, auch wenn die Integration auf dem Wafer für die Ingenieure zum absoluten Albtraum werden dürfte.

Ein weiterer kritischer Punkt ist die Fertigungstiefe mit dem 16-hi Stack. 16 Schichten DRAM übereinander zu stapeln und dabei die Signalintegrität bei 10 GT/s zu gewährleisten, grenzt an schwarze Magie. Wir reden hier sehr wahrscheinlich über fortschrittliches Hybrid Bonding, bei dem die Verbindungen direkt Kupfer-auf-Kupfer erfolgen, ohne die traditionellen Löthügel (Microbumps). Das ermöglicht nicht nur die extreme Packdichte für die 48 GB Kapazität, sondern verbessert auch die thermische Leitfähigkeit innerhalb des Stacks. Für den Endkundenmarkt bleibt diese Technologie jedoch vorerst Utopie – die Kosten für einen solchen Stack dürften höher sein als die meisten kompletten Gaming-PCs.

- Enorme 48 GB Dichte pro Chip spart Platz

- Effizienzsprung durch breites 2.048-Bit Interface

- Zukunftssicher für riesige KI-Modelle

- Extrem hohe Fertigungskosten (nichts für Gamer)

- Komplexes Packaging erfordert neue Interposer

- Abwärme bei 16 Schichten bleibt Herausforderung

💡 Unsere Einschätzung zu HBM4

Machen wir uns nichts vor: Diese Technologie ist pures Gold für Hyperscaler wie Google, Microsoft oder Meta und Hardware-Schmieden wie Nvidia. Wer professionell LLMs trainiert oder komplexe wissenschaftliche Simulationen fährt, wird HBM4 mit Kusshand nehmen. Die Möglichkeit, Speicherbandbreite und Kapazität in diesem Maße zu skalieren, löst eines der dringendsten Probleme im aktuellen KI-Hype-Zyklus. Es ermöglicht effizientere Rechenzentren, da mehr Workload auf weniger Chips bewältigt werden kann, solange der Speicher nicht limitiert.

Für den klassischen PC-Enthusiasten oder Gamer ist diese News eher ein technologischer Ausblick als eine Kaufberatung. Die Komplexität des 2.048-Bit Interfaces macht es extrem unwahrscheinlich, dass wir HBM4 in naher Zukunft auf einer GeForce oder Radeon sehen werden – zumindest nicht im Consumer-Segment. Dort regiert GDDR (bald GDDR7) aufgrund des besseren Preis-Leistungs-Verhältnisses weiter. Aber wie so oft im Tech-Bereich: Was heute im Serverraum startet, beeinflusst die Architekturen von morgen. Wir sehen hier die Speerspitze dessen, was physikalisch machbar ist.

Perfektes Setup zum Thema

NVIDIA GeForce RTX 4090

Während HBM4 noch im Labor glänzt, ist dies das Maximum an VRAM (24 GB) und KI-Power, das du aktuell in deinen privaten Rechner stecken kannst.

🏁 Fazit

SK Hynix hat geliefert und zeigt, dass das Ende der Fahnenstange bei Speichertechnologien noch lange nicht erreicht ist. Mit 48 GB Kapazität und dem massiven 2.048-Bit Interface ist HBM4 genau der Sauerstoff, den die KI-Industrie zum Atmen braucht. Es ist ein faszinierendes Stück Ingenieurskunst, das zwar (noch) unerschwinglich ist, aber die Weichen für die Rechenleistung der kommenden Jahre stellt.

Mehr Deep Dives findest du in unserem News-Radar.

Quelle: Originalbericht lesen

🤖 Transparenz: AI-Content

Unglaublich, aber wahr: Dieser Artikel wurde zu 100% vollautomatisch von einer KI recherchiert, geschrieben und formatiert. Ich habe keinen Finger gerührt.

Willst du wissen, wie ich diesen Tech-Blog automatisiert habe? Ich habe mein komplettes System (Make.com Blueprints & Prompts) offengelegt.